🎈A/B Testing : arrête avec ces 3 erreurs | #112

Ça peut te faire perdre du temps et de l'énergie...

Hello 👋

Bienvenue dans cette édition 112 de La Cargaison, la newsletter CRO/UX qui t’aide à booster les conversions de n’importe quel site web.

Au programme cette édition :

Que faire quand ton client ou ton boss veut tester n’importe quoi ?

Comment tester quand tu as peu de trafic ?

Faut-il vraiment faire des A/B tests en continu ?

Tester toute sa page : bonne ou mauvaise idée ?

Une check-list complète pour réussir tes A/B tests

Pour booster tes conversions à coup sûr

Une formation vidéo et des ressources pour booster les conversions de n’importe quel site.

Le guide pour vraiment réussir ses A/B tests

L’A/B testing est l’outil préféré de nombreux marketers – à juste titre.

C’est une méthode puissante pour optimiser ses performances.

Mais mal utilisée, elle peut vite devenir une perte de temps… voire pire.

Voici 3 erreurs à éviter à tout prix :

1 - AB testing basé sur aucune recherche (ou écouter son boss)

Un inscrit à ma formation s’est pris une remarque par client.

La raison : des A/B tests qui rapportent 0 résultat.

Le problème de cette remarque :

Ils ont effectué seulement 3 tests A/B…

Le client propose donc de meilleures hypothèses à tester.

Autre problème :

Ce client se base sur son intuition.

Du genre :

“j’ai vu sur le site de mon concurrent qu’ils utilisaient l’IA pour leurs images, testons la même chose”

Comment réagir face à ce genre de situation ?

→ Expliquer qu’il est impossible d’obtenir des résultats sur 100% des tests A/B

→ Expliquer que les tests A/B font partie du process d’apprentissage

→ Expliquer que les tests A/B permettent d’affiner les futurs tests

Si vraiment le client est insistant :

Teste son idée !

Dans tous les cas, ça peut être bénéfique :

→ Le test échoue : cela prouve qu’il faut une méthode plus rigoureuse pour imaginer des hypothèses d’optimisation.

→ Gagnant : tout le monde est content, et votre client veut sûrement plus de tests (et donc plus de CRO)

Ne perds pas ton temps à débattre d’une idée pendant des plombes.

Teste, analyse et faits de la recherche.

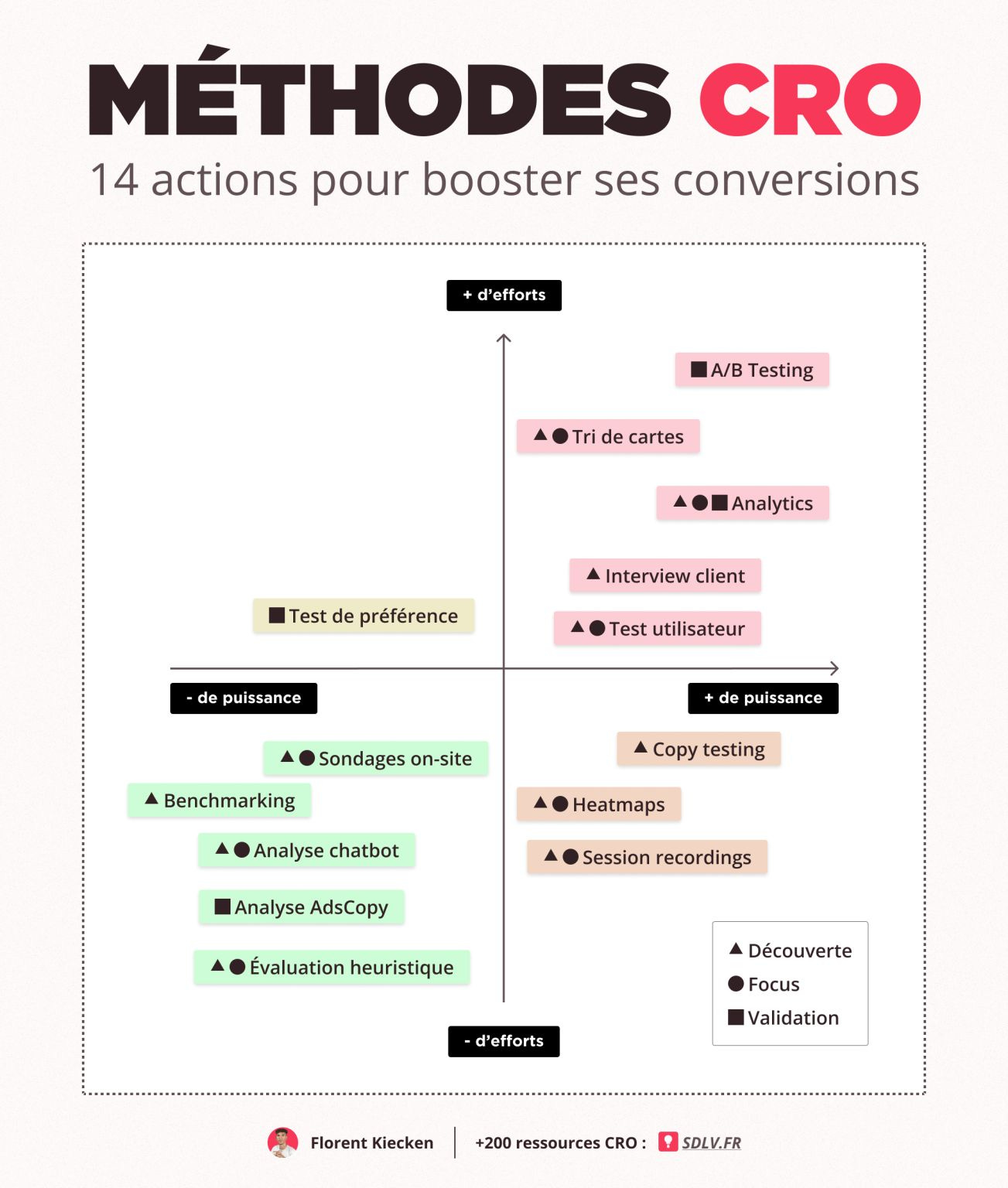

Avec ce genre de méthodes :

2- AB testing avec peu de trafic

C’est une erreur ultra fréquente, même chez des “gourous” bien connus.

8 conversions vs 6 sur 300 visiteurs ? Ça n’a aucune valeur.

Si tu n’as pas au moins 20k visiteurs/mois, ou 200 conversions/variante sur 5 semaines → oublie le test.

À la place :

→ Vise des changements radicaux.

→ Attends-toi à des résultats de +50%, voire +100% pour détecter une vraie différence.

Pour être sûr, utilise un calculateur comme celui de Speero.

3 - AB testing en dessous de la ligne de flottaison

Non, ce n’est pas une erreur en soi.

Mais il faut garder en tête :

Tous les visiteurs ne voient pas les éléments en dessous de la ligne de flotaison.

Et pourtant, 100% des visiteurs sont pris en compte dans les résultats.

Ce qui fausse potentiellement toute l’analyse.

💡 Astuce : utilise un script de “vue d’élément” pour analyser uniquement les visiteurs ayant vu le changement (via GA, par exemple).

Et pense à ajuster ton calcul de test en fonction du Minimum Detectable Effect (MDE).

La check-list pour un A/B test réussi

Faire des tests A/B régulièrement m’a poussé à faire une check-list pour ne rien oublier.

Résultat : une check-list complète que j’utilise systématiquement avec mes clients.

Elle t’aidera à éviter les oublis, les biais, et à cadrer chaque test correctement.

Sauvegarde-la et sors-la à chaque nouvelle campagne.

Voilà pour cette édition.

À très vite pour la prochaine cargaison.

Et en attendant : teste intelligemment !

Florent